Šiandien vaizdo klastotės turi gana neigiamą konotaciją, tačiau pirmieji bandymai vykdyti tikrai ne piktavaliais sumetimais, tikina DI technologijų kūrėjas, VILNIUS TECH Elektroninių sistemų katedros vedėjas prof. dr. Artūras Serackis.

Anot jo, tokių technologijų vystymąsi lėmė paprasčiausias noras DI pagalba generuoti žmonių atvaizdus ir kitus vaizdus. Iš pradžių vaizdai buvo netobuli, neryškūs ir stokojantys detalių, tačiau dabartiniai DI sprendimai leidžia sugeneruoti bet kurio žmogaus veidą, balsą, įkelti suklastotą asmens atvaizdą į vaizdo įrašą ar net tiesioginę transliaciją. Tokios klastotės dažnai naudojamos norint pajuokauti ir pasilinksminti, o kartais gali atnešti ir nemažai naudos.

„Yra DI technologijos, leidžiančios sukurti žmogaus skaitmeninį dvynį, šnekantį tuos pačius dalykus, tačiau kita kalba, – pasakoja prof. dr. A. Serackis. Tokie sprendimai galėtų būti pritaikomi kino industrijoje. – Įsivaizduokite – nueinate į kino teatrą ir vietoje to, kad skaitytumėte titrus, ar girdėtumėte kitų žmonių įgarsinimą, matytumėte savo mylimiausią aktorių, kalbantį lietuviškai, tačiau savo balsu. Būtų didžiulis efektas.“

Nors toks prototipas kol kas nėra įgyvendinamas, skaitmeninį dvynį galima puikiai pritaikyti studijų procese. DI segeneruotas „virtualus mokytojas“ – puikus pagalbininkas dėstytojams, ypač – šiais laikais.

„Pastebėjome, kad studentai labiau mėgsta tuos studijų dalykus, kuriuose yra galimybė paskaitos vaizdo įrašus peržiūrėti vėliau, tačiau kai kuriems dėstytojams tai sukelia diskomfortą. Tuo tarpu „virtualus mokytojas“ su dėstytojo, ar kito žmogaus veidu pagal pateiktą medžiagą sukuria vaizdo įrašą, kurį galima perklausyti kad ir kelis kartus. Be to, jei kažkokie fragmentai, formulės ar metodai toje paskaitoje paaiškinti nesuprantamai, galima paprašyti DI pateikti kitą vaizdo įrašą, kuriame „dėstytojas“ papasakos daugiau detalių arba kitaip sukonstruos pasakojimą“, – dalijasi VILNIUS TECH profesorius.

Daugėja grėsmių

Nors tobulėjantys DI įrankiai leidžia kurti vis įspūdingesnes, tikroviškesnes klastotes, kartu tai sukelia ir daugiau grėsmių. Nors pačios technologijos savaime nėra blogos, ar skirtos apgavystėms vykdyti, jos – lengvai prieinamos, tad jomis gali pasinaudoti visi žmonės, net ir tie, kurių kėslai – ne patys doriausi, sako prof. dr. A. Serackis.

Neretai vaizdo klastotės naudojamos rinkimų metu, siekiant diskredituoti politikus ir kitaip jiems pakenkti. Vis dėlto, rinkimai nėra ta sritis, kur vaizdo klastotės naudojamos dažniausiai ir padaro didžiausią žalą. Moterų žurnalistikoje koalicija (angl. – The Coalition For Women In Journalism) atliko tyrimą, kurio metu nustatė, kad per pastaruosius dvejus metus daugiausiai žalos padarė klastotės, naudotos patyčioms skatinti, dezinformacijai skleisti ir pornografijoje.

„Vienas iš pavyzdžių – atvejis JAV, kai Carmel High School mokiniai suklastojo mokyklos direktoriaus atvaizdą ir išplatino įrašą, kuriame jis neva peikė juodaodžius moksleivius ir taip įžeidė didelę bendruomenės dalį. Vis tik įžeista bendruomenė nesulaukė tinkamos reakcijos iš mokyklos, tad jos vadovybei net norėta iškelti ieškinius. Tokia pati klastotė buvo panaudota ir kitoje mokykloje.

Kartais žmonių atvaizdai panaudojami ir pornografiniuose filmuose, vaizdo įrašuose ir dar yra paviešinami. Tai – sudėtingi ir itin jautrūs atvejai, nes dažniausiai tokie įrašai platinami privačiuose, ar nelabai kontroliuojamuose kanaluose“, – dalijasi prof. dr. A. Serackis.

Atpažinti vaizdo klastotes – įmanoma

Vis dėlto, profesorius tikina, kad net ir aukščiausios kokybės išmaniąją vaizdo klastotę atpažinti įmanoma, ypač tada, kai veidas vaizdo įraše juda. Pasitaiko, kad vaizdo klastotės pasitelkiamos tiesioginių transliacijų, ar vaizdo pokalbių metu, tačiau tokiu atveju naudojamos kiek paprastesnės DI technologijos, kurias lengviau atpažinti.

„Jei matote, kad žmogus atrodo ne taip, kaip turėtų, paprašykite pasukti galvą 90 laipsnių kampu arba pamojuoti ranka priešais veidą ranka. Jei tai – klastotė, sutriks veido atpažinimo ir vaizdo generavimo procesas. Tai – paprastas, praktinis pavyzdys, tačiau svarbus, nes tokie įrašai padaro tikrai daug žalos“, – pataria VILNIUS TECH mokslininkas.

Prof. dr. A. Serackis ragina atkreipti dėmesį ir į vaizdo įrašuose matomą foną – dėl ribotų technologijų jis dažniausiai būna baltas, apšvietimas – tolygus, beveik nėra šešėlių.

Tuo tarpu atpažinti, ar nuotraukos suklastotos, ar ne, gali padėti DI daromos klaidos, dažnai susijusios su žmogaus anatomija – pavyzdžiui, pavaizduojama per daug ar per mažai pirštų. Vaizdo klastotes išduoda ir įvairios funkcionalumo anomalijos, ar neveikiantys fizikos dėsniai, kurių iš pirmo žvilgsnio kartais ir nepastebime – pavyzdžiui, keisto ir nelabai įmanomo atspindžio veidrodyje.

Įtarimų gali sukelti nuotraukose vaizduojamos neįprastos situacijos, socialinės, ar kultūrinės anomalijos, pavyzdžiui, viešai besiglėbesčiuojantys japonai, nes artimas ir viešas fizinis kontaktas šiai tautai nėra būdingas.

„Dar įdomesnis dalykas – biometriniai artefaktai. Kai generuojama vaizdo klastotė su žinomu žmogumi, tam tikri bruožai gali būti sugeneruoti neteisingai, pavyzdžiui, ausies forma. Kiekvieno žmogaus ausys – unikalios, kaip ir pirštų antspaudai, todėl gali būti naudojamos asmens atpažinimui. Be to, DI sugeneruotos nuotraukos dažnai būna per daug stilizuotos, bruožai – išplauti, o spalvos – per daug išraiškingos“, – dalijasi Elektroninių sistemų katedros vedėjas.

VILNIUS TECH mokslininkų kuriamas DI įrankis – operatyviam klastočių atpažinimui

Vaizdo klastočių atpažinimui taip pat yra kuriamos išmanios technologijos. Šiuo metu prof. dr. A. Serackis su komanda kuria inovatyvų DI sprendimą, kuris leis akimirksniu identifikuoti vaizdo klastotes, ypač tas, kurias sugeneravo DI, ir taip užkirsti kelią manipuliacijoms vaizdu informacinėje erdvėje.

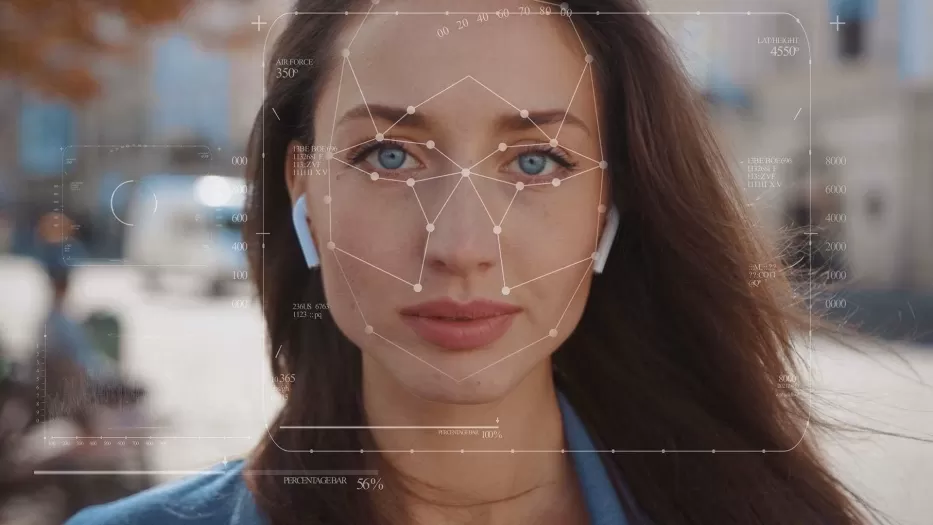

„Mūsų kuriamas sprendimas, naudojantis vaizdo atpažinimo technologijas, geba nustatyti ir analizuoti itin didelį kiekį veido taškų – stebime veido raumenų judesių, mimikos, net akies vyzdžio pokyčių seką ir galime identifikuoti, ar šie pokyčiai yra sugeneruoti“, – sako mokslininkas.

Tiesa, kad šis prototipas aptiktų klastotę, reikia naudoti ilgesnius vaizdo įrašus, kuriuose judėtų žmogaus galva ir veido raumenys. Tai kiek apriboja įrankio taikymą ir verčia ieškoti kompromisų, tačiau profesorius tikina – vaizdo klastočių aptikimo įrankių kūrimas yra nesibaigiantis, iššūkių kupinas procesas, reikalaujantis vis išmanesnių sprendimų.

„Kartais DI daromos klaidos atrodo juokingos ir lengvai atpažįstamos, tačiau jeigu pats DI nesugeba atskirti, kiek ir kokių rankos pirštų reikia sugeneruoti, sukurti sprendimą, kuris tas klaidas automatiškai aptiktų ir atpažintų, yra didelis iššūkis. Vos sukurtos technologijos, kurios tas klaidas atpažįsta, pereina į generatyvinį dirbtinį intelektą.

Taigi, kas veikė prieš pusmetį, šiandien jau nebeveikia, tad savo prototipą vis tobuliname. Naudojame naujausius vaizdo klastočių kūrimo įrankius, kad jį „apgautume“, o tuomet ieškome naujų būdų, kaip šios apgaulės išvengti. Stebime, kaip kiti tyrėjai aptinka vaizdo klastotes ir stengiamės savo prototipą papildyti panašiais sprendimais. Be to, tampa aktualu atpažinti ir vaizdo įrašų montažą, kai asmuo vaizduojamas aplinkoje, kurioje nėra buvęs, rodoma, jog apsilankė kokiame nors mieste, nors realiai į jį nebuvo atvykęs. Tai kiek kitokių technologijų reikalaujantis klastotės aptikimo iššūkis, tačiau ir šiam uždaviniui ieškome sprendimo“, – dalijasi prof. dr. Artūras Serackis.